เปลี่ยน look ของเราใน video ให้ดูเป็น OPB มืออาชีพด้วย AI

แนะนำตัว

ผมคือใคร (อันนี้ต้องอวยตัวเองแบบคุณเกมแนะนำ)

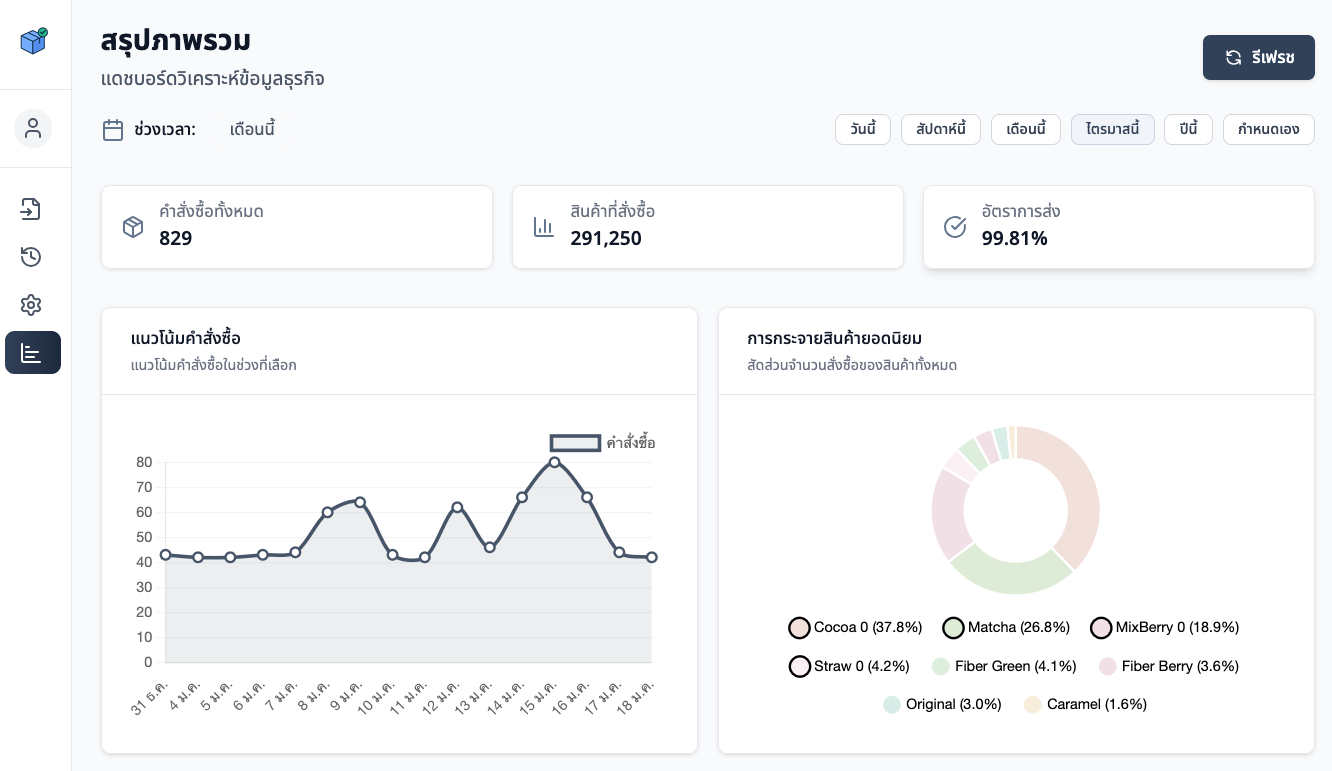

- คนที่สร้างเครื่องมืออ่านเอกสารคำสั่งซื้อที่เป็น PDF จาก modern trade ในไทย และลดเวลากรอกข้อมูลให้ SME ไปได้ 3 ชั่วโมงต่อวัน

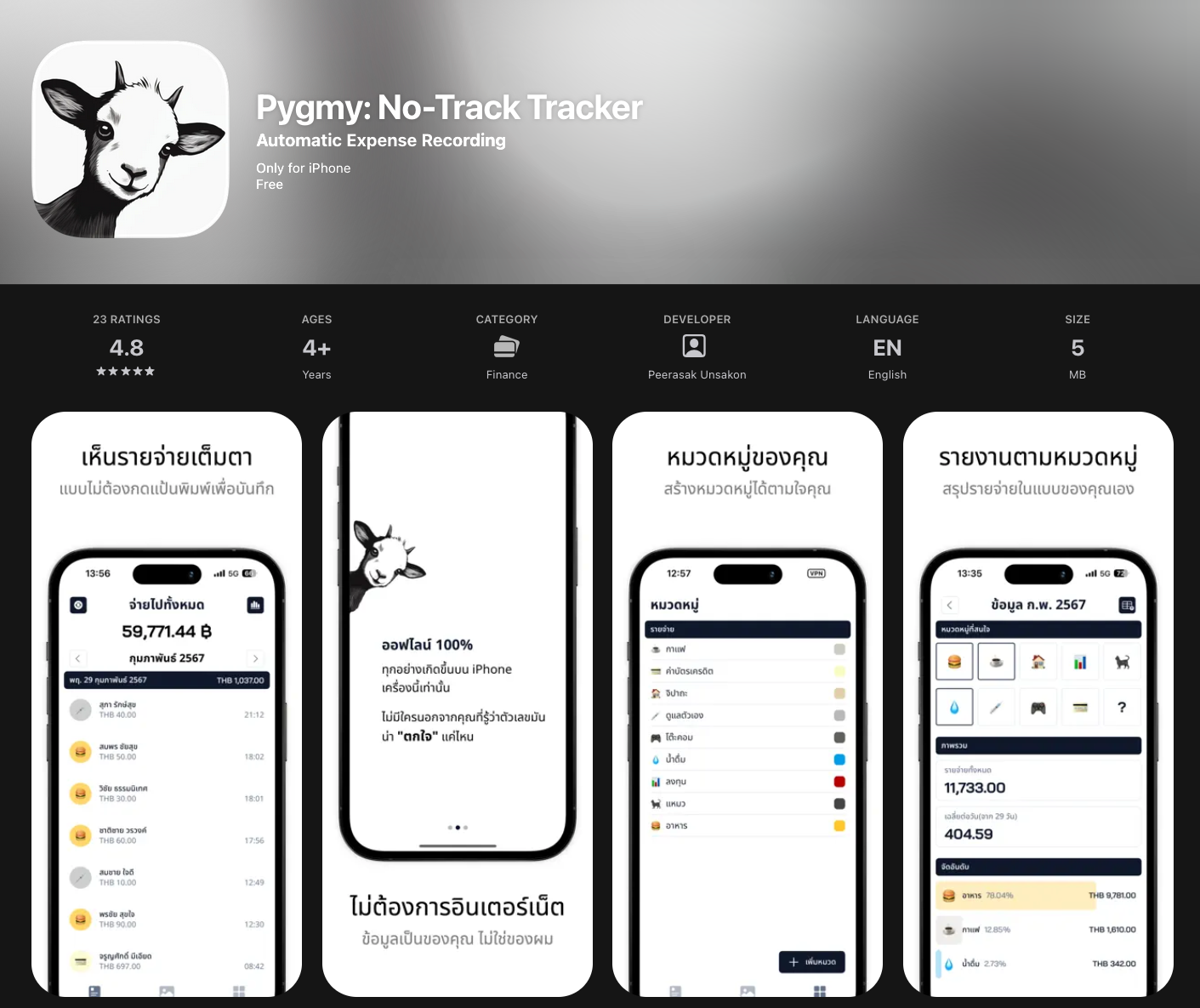

- คนที่ทำให้คนใช้ iPhone 1000+ คน ไม่ต้องจดรายจ่ายด้วยมือ แต่ใช้ iPhone ทำงานแทนได้ทุกวัน โดยไม่ต้องพึ่งพา internet หรือ server ข้างนอก (รู้สึกว่าซื้อ iPhone มาคุ้่มค่าขึ้นรึยัง 😅)

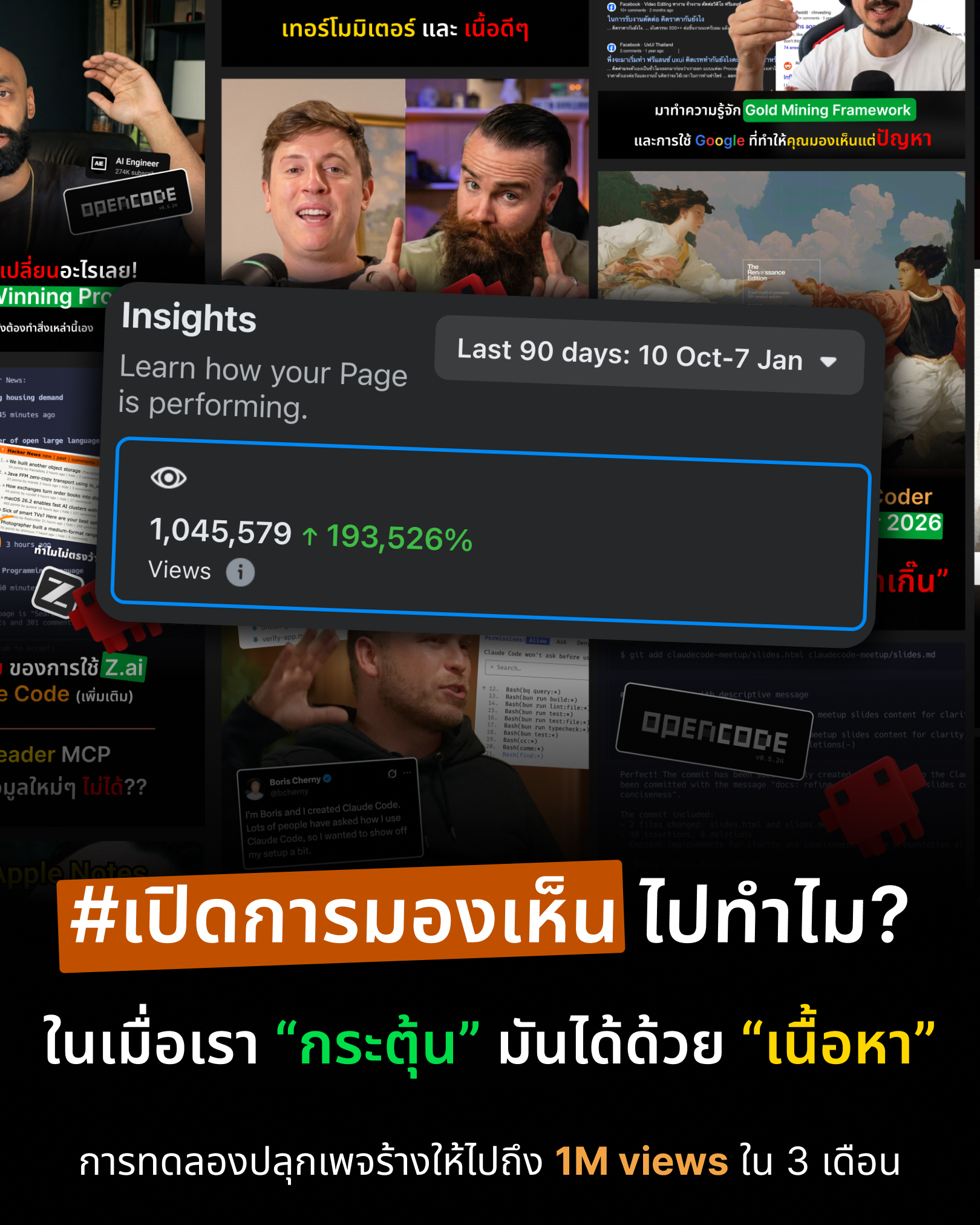

- คนที่เขียนบทความบทบน Facebook และสร้างผู้ติดตามหลักพันและทำให้มียอดวิวบทความไปถึงล้านใน 3 เดือน

ปัจจุบันกำลังเป็น OPB ฝึกหัด และรู้ตัวดีว่าการจะเป็น OPB ที่ดี การนำเสนอและการขาย

นั้นสำคัญไม่แพ้กับการสร้างของหรือการพัฒนาตัวเองให้เป็น version ที่ดีกว่าในปี 2026

จะเห็นว่าผมอยู่เบื้องหลัง keyboard และจอมาตลอด แต่ไม่เคยออกมาหน้ากล้องเลย

เลยคิดว่าในปีนี้อีก version ที่ผมอยากจะ upgrade ไปให้ได้ คือ ไปเป็นคนที่สามารถพูดหน้ากล้อง สอนคน ได้จริง (แม้จะออนไลน์ก็ตาม)

เลยเป็นที่มาของ session นี้

นี่ไม่ใช่ workshop แต่เป็นการ share สิ่งที่ผม research มา

จากมุมของคนที่อยู่หลังกล้องวมาตลอดด และอยากรู้ว่าเราจะไปอยู่หน้ากล้องยังไงให้ "มั่นใจ" แม้จะไม่กี่วินาทีก็ตาม

เริ่มเข้าเนื้อหา

ช่วงนี้หลายคนน่าจะเห็นพวก video คลิปที่ ใช้เปลี่ยนคนใน video ให้กลายเป็นคนอื่น เป็นนักแสดง หรือเซเลป

You could build a bespoke influencer right now using only AI.

— A.I.Warper (@AIWarper) January 16, 2026

Scrape clips or record yourself.

Automate the rest:

- scrape

- LLM audit

- bucket by category

- process

- voice changer

This stack already works - the real unlock is realtime.

Clips: Emiru, gabimfmoura pic.twitter.com/H72qqxKrh5

We’re not prepared for how quickly production pipelines are going to change with AI.

— Justine Moore (@venturetwins) January 14, 2026

Some of the latest video models have immediate implications for Hollywood - endless character swaps at a negligible cost.

(this is from ederxavier3d on IG using Kling Motion Control) pic.twitter.com/CEwOGCHogW

Here’s a Kling Motion example.

— Alex Patrascu (@maxescu) January 17, 2026

The twist?

The driving video of me is also AI 😮 pic.twitter.com/54vPpznFDD

we're so cooked pic.twitter.com/NZDKNrfXhk

— Fraser Cottrell | Ad Creative For Meta & TikTok (@sourfraser) January 17, 2026

เครื่องมือตัวนี้มันดูดี มันเจ๋งมาก กับการเอามาทำ content หรือแม้แต่ video ขายของ

แต่ว่า "เรากำลังหลอกลูกค้า" อยู่รึเปล่า

- รีวิว ทั้งที่ไม่เคยจับ ไม่เคยใช้

- คนที่พูดในคลิป ก็ไม่เคยมีตัวตน (หรือไปแอบอ้างอันนี้ยิ่งน่าโกรธ)

แล้วเราจะอยากเป็นคนอื่นไปทำไมล่ะ?

ทำไมเราไม่เป็นตัวเอง

- ใน version ที่ดีขึ้น (หรือแค่ดูดี)

- สิ่งที่เราพูด มันก็คือเราเอง เสียงของเรา

ทั้งหมดนี้เลยเป็นที่มาของ Sharing session วันนี้เลยครับ ผมจะเล่าให้ฟังว่า

- ผมไปลองอะไรมาบ้าง

- ผมได้ผลลัพธ์ยังไง

- ผมเสียเงินไปเท่าไหร่

- อนาคตจะใช้จริงได้ไหม

ผมไปลองอะไรมาบ้าง

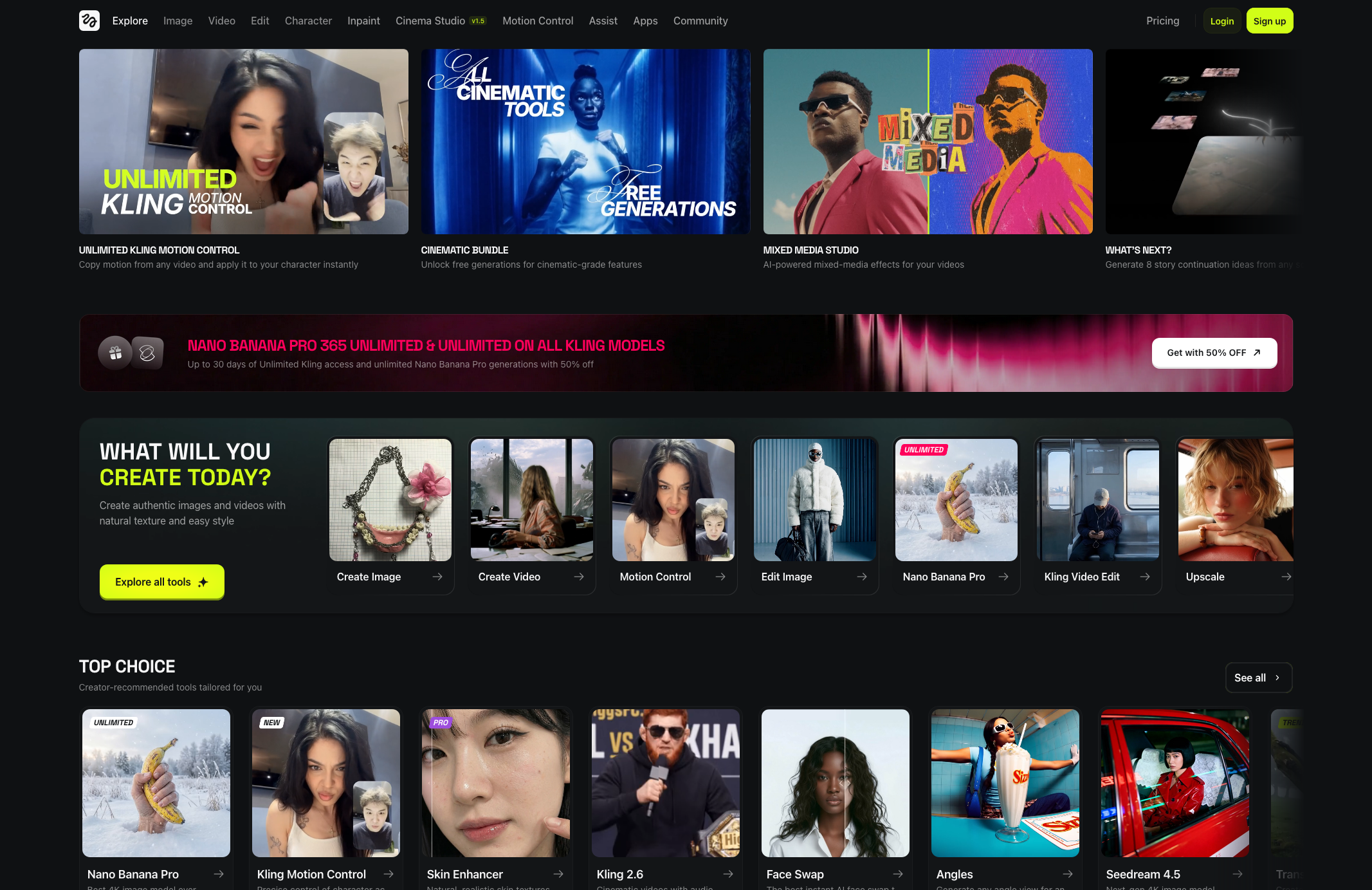

จากที่เห็นกันตาม X หรือ social network ที่ Hype กันมากๆ ตอนนี้

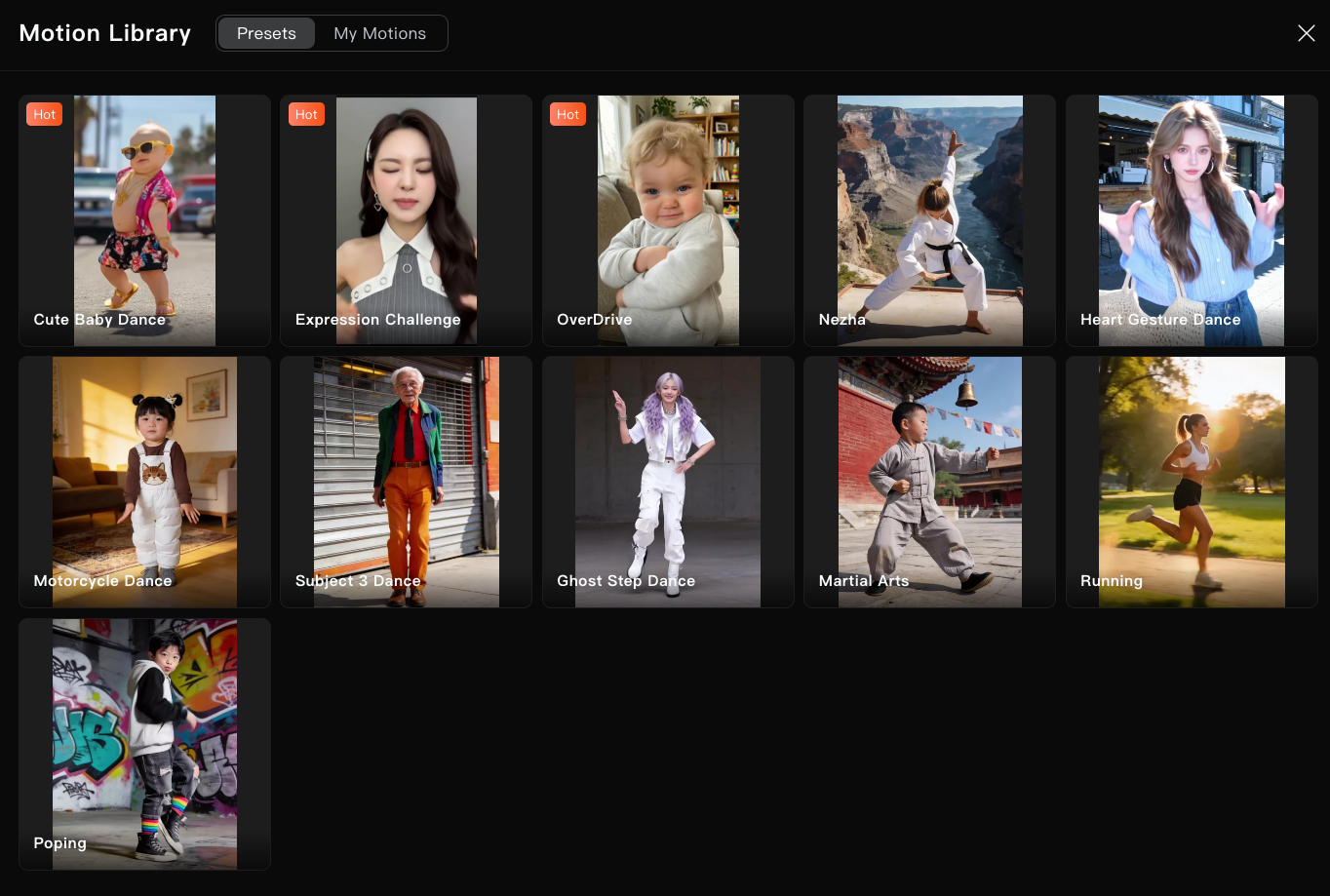

เกือบทัั้งหมดเป็นฝีมือของ model สร้าง video ที่ชื่อว่า Kling 2.6 - Motion Control

และเป็นตัวหลักที่ผมทดลองให้ดูในวันนี้ด้วย

เล่ากันคร่าวๆ นี่เป็น model สัญชาติ “จีน” อีกตัวครับ เจ้าของคือ Kuaishou Technology

โดย Kling AI model เพิ่งเปิดตัวเมื่อ 2024 นี่เองครับ 2 ปีเองมาไกลมาก

ความสามารถของ Kling Model เองจริงๆก็มีหลากหลายครับ

-

Image generation (เหมือนชาวบ้าน แต่ผมว่าใช้ Nano Banana Pro เถอะถ้าเป็นตอนนี้)

- จาก text เฉยๆ ไปเป็นรูปเลย

- จาก รูป + text ไปสร้างเป็นรูปใหม่ (subject reference)

- เปลี่ยน style ของภาพได้ เช่น จากรูปจริง selfie ให้กลายเป็นตัวการ์ตูน (ที่เราทำๆกันแบบ Ghibli แบบนั้นแหละ)

-

Video generation (อันนี้ตัวเด่นของเจ้านี้)

- จาก text มาเป็น video ก็ตรงๆ

-

จาก image ไปเป็น video แต่มันเจ๋งตรงที่

- มันจะให้เราใส่ภาพ frame แรกและ frame สุดท้ายของคลิปได้ แปลว่าเรากำหนดได้ว่าคลิปนี้จะดำเนินไปทางไหน (เอาไปประยุกต์กับงานจริงได้เยอะเลย)

-

พระเอกของวันนี้ “Motion Control”

- เราสามารถเอา video อะไรก็ได้ที่มีความยาว 3 - 30s มาใช้เป็นคลิปต้นแบบการเคลื่อนไหว แล้วก็กำหนดภาพที่เราอยากให้มันขยับแบบเดียวกับใน video ต้นแบบ ซึ่งมันไม่ได้เอาแค่การเคลื่อนไหวของร่างกายมาใช้เป็นต้นแบบอย่างเดียว แต่รวมถึง

- การแสดงสีหน้า

- การขยับปาก

- เราสามารถเอา video อะไรก็ได้ที่มีความยาว 3 - 30s มาใช้เป็นคลิปต้นแบบการเคลื่อนไหว แล้วก็กำหนดภาพที่เราอยากให้มันขยับแบบเดียวกับใน video ต้นแบบ ซึ่งมันไม่ได้เอาแค่การเคลื่อนไหวของร่างกายมาใช้เป็นต้นแบบอย่างเดียว แต่รวมถึง

แต่ Kling Model เนี่ยเราสามารถเลือกใช้บริการได้จาก service หลายๆเจ้าครับ

- Klingai.com เจ้าของเอง

- Higgsfield.ai เจ้านี้ก็ดีครับ รวม model จากหลายๆเจ้ามาให้เราใช้ที่เดียว

- และอีกเยอะเลยครับ Runway AI, Replicate แต่ไม่ขอยกมาเยอะละกัน

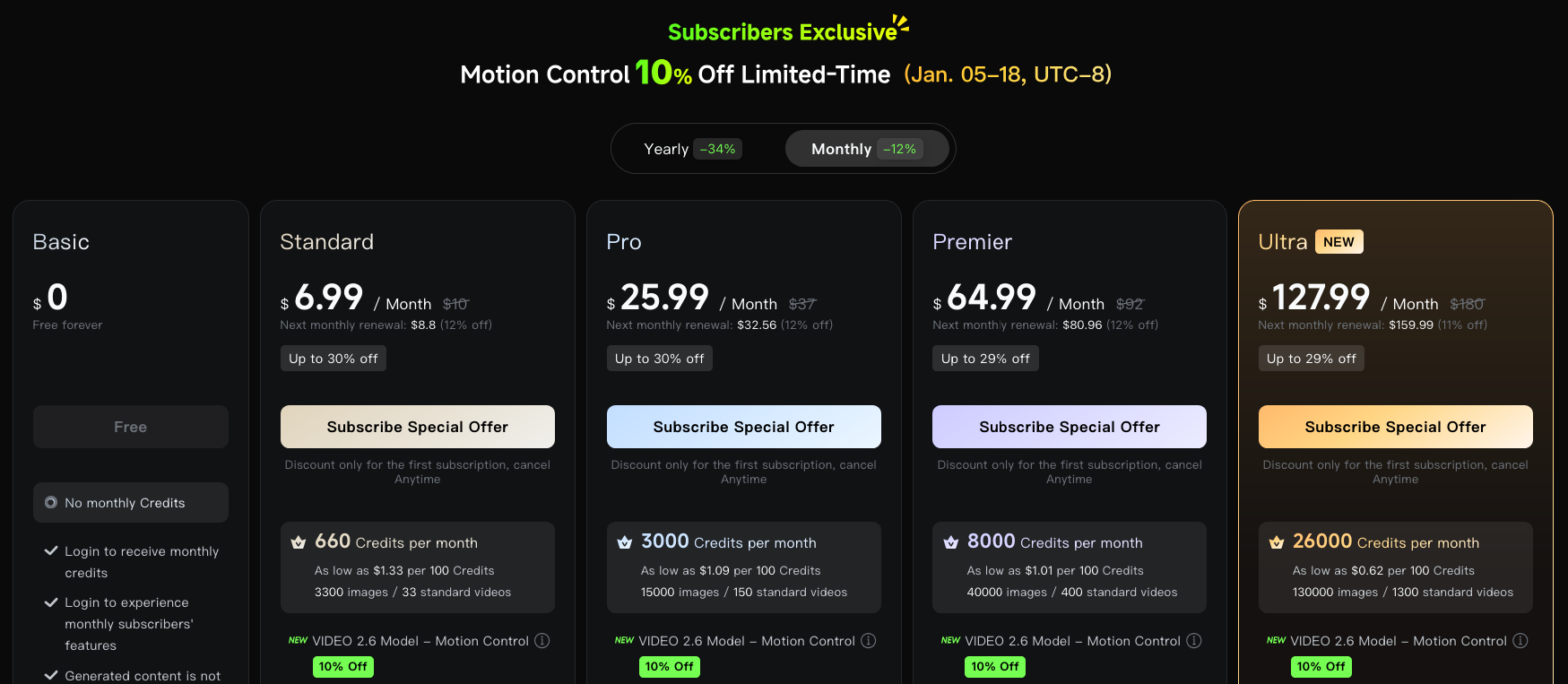

ผมเลือกใช้ Kling AI ครับ เพราะว่าค่า subscription เริ่มต้นถูกที่สุด $6.99 แล้วตอนสมัครครั้งแรกก็จะมี credit ฟรีให้ได้ลองด้วยนิดหน่อย (นิ๊ดจริงๆ)

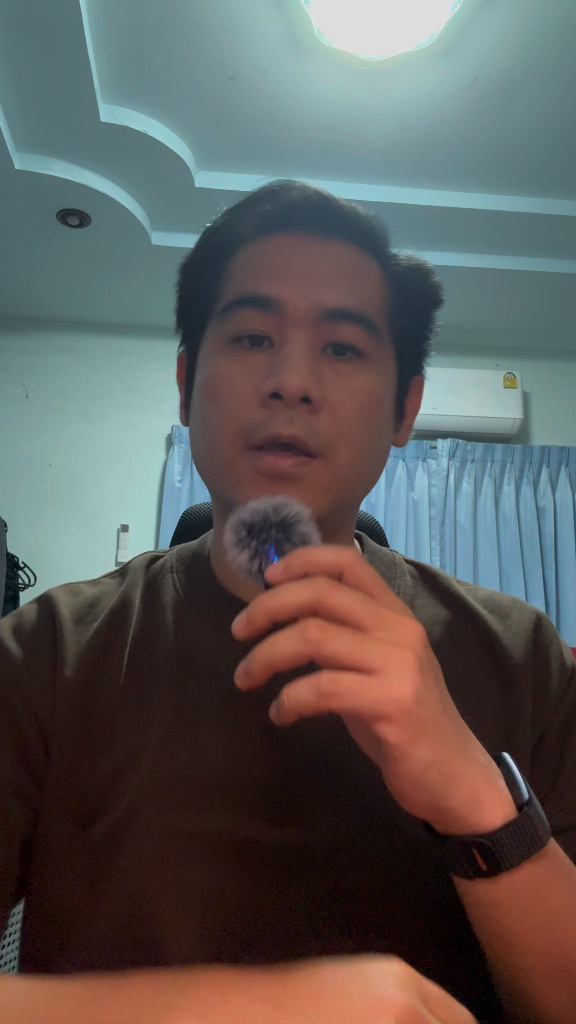

การทดลองก็คือ

-

ผมอัดคลิป 16 วินาทีแบบที่ทุกคนเห็นนั่นด้วยมือถือในห้องของตัวเองที่ไม่ได้จัดไฟอะไรด้วยมือถือ

-

ผม capture รูป frame แรกๆของ video เอาไว้ แล้วเอาไปบอกให้ Gemini 3 Pro (Nano Banana Pro) ช่วยเนรนิตห้องมืดๆ ให้กลายเป็นฉากที่อบอุ่น แสงดูเป็นธรรมชาติ ให้ดูดีหน่อย ซึ่งก็ลองใช้ prompt ปรับกันดูครับ

Before (Original Frame)

Before (Original Frame) After (Gemini Ref)

After (Gemini Ref)

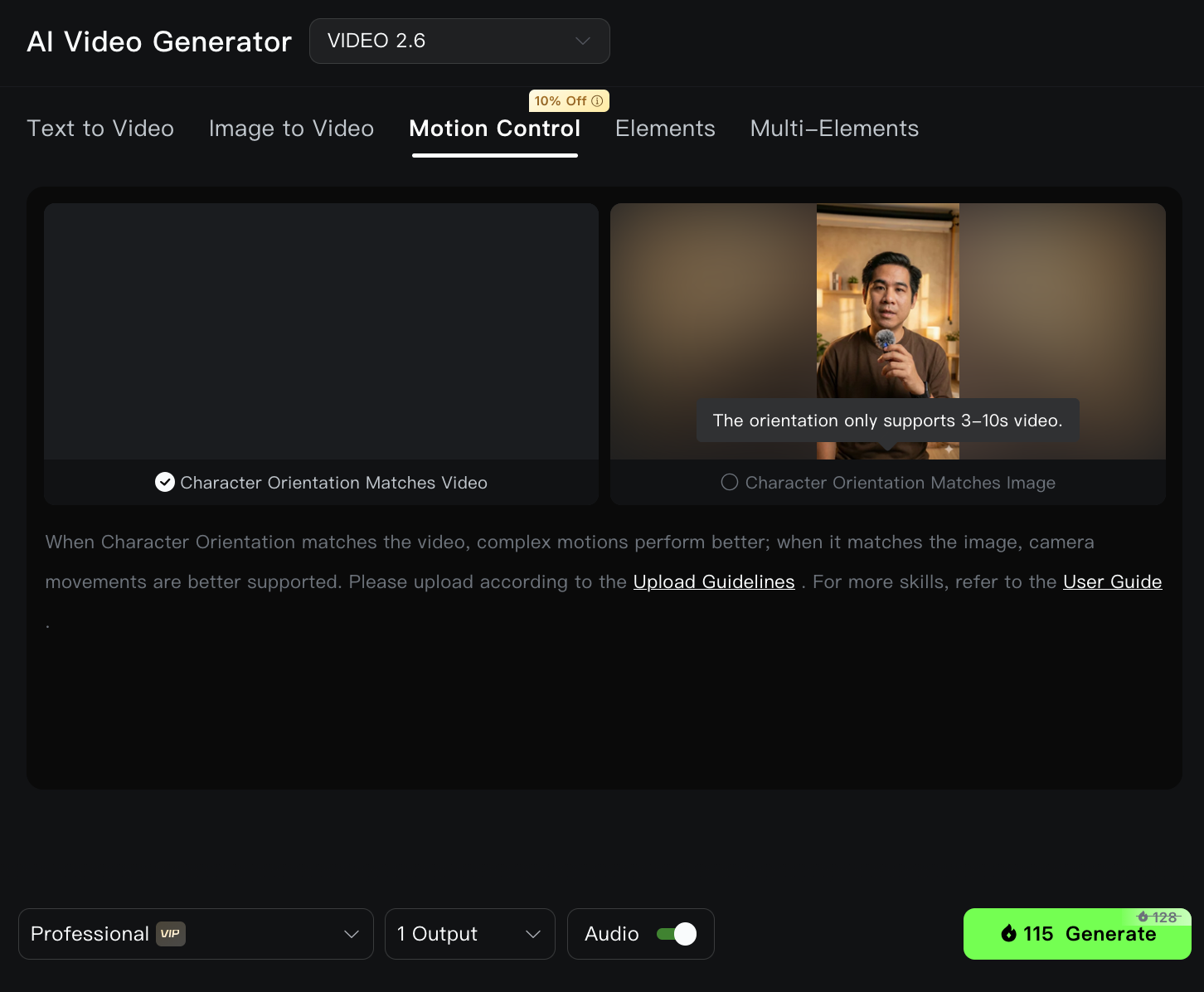

Re-create a perfect studio scene from the input image. Do not change the person in the video, except for the quality of the light, which should be warm and natural. The scene should be a warm, cozy, minimal room with professional studio lighting. Make it realistic. Keep the same angle and perspective. Aspect ratio: 9:16- เปิด Kling AI เข้าไป AI Video Generator แล้วก็เลือก Motion Control แล้วก็ลาก video ต้นแบบ และรูปภาพเราใน version ที่ดูดีมาวางข้างๆกัน

-

ข้อนี้ต้องเลือกดีๆ มันคือการเลือก Orientation Matches ซึ่ง Kling มีให้ 2 แบบคือ

1. Character Orientation Matches Video (ค่าเริ่มต้น) < 3 - 30 วินาที >

- แบบนี้คือการยึดตาม "วิดีโอต้นแบบ" เป็นหลักครับ

- การทำงาน: AI จะสร้างวิดีโอโดยเลียนแบบทั้งการเคลื่อนไหว (Movements), สีหน้า (Expressions), มุมกล้อง (Camera Movements) และ ทิศทางการหันหน้า (Orientation) มาจากวิดีโอต้นแบบทั้งหมด

- เหมาะสำหรับ:

- งานที่คุณต้องการ "คัดลอก" แอคติ้งและมุมมองจากวิดีโอต้นแบบมาแบบเป๊ะๆ

- กรณีที่คุณพอใจกับมุมกล้องของวิดีโอต้นแบบอยู่แล้ว และอยากให้ตัวละครในรูปภาพขยับตามนั้น 100%

- ข้อจำกัด: คุณจะควบคุมมุมกล้องผ่าน Prompt ได้ยาก เพราะ AI จะพยายามล็อคมุมกล้องให้เหมือนกับวิดีโอต้นแบบ

2. Character Orientation Matches Image < 3 - 10 วินาที >- แบบนี้คือการยึดตาม "รูปภาพต้นฉบับ" เป็นหลักครับ

- การทำงาน: AI จะดึงแค่การเคลื่อนไหวและสีหน้ามาจากวิดีโอต้นแบบ แต่จะตรึง ทิศทางการหันหน้า (Orientation) ให้เหมือนกับในรูปภาพที่คุณอัปโหลด

- เหมาะสำหรับ:

- งานที่ต้องการควบคุม มุมกล้อง (Camera Movement) เองผ่าน Text Prompt เช่น สั่งให้ Zoom In, Zoom Out, แพนกล้องขึ้น-ลง หรือสั่งให้กล้องนิ่ง (Fixed Position)

- กรณีที่ท่าทางในวิดีโอต้นแบบดี แต่ทิศทางการหันหน้าไม่ตรงกับรูปภาพของคุณ (เช่น ในรูปหันขวา แต่ในวิดีโอหันซ้าย) โหมดนี้จะช่วยรักษาทิศทางของรูปเดิมไว้ได้ดีกว่า

- ข้อจำกัด: อาจจะดูไม่ลื่นไหลเท่าแบบแรกถ้าท่าทางในวิดีโอกับมุมในรูปขัดแย้งกันมากๆ

ที่บอกว่าสำคัญคือนี่ต้องคิดตั้งแต่ตอนที่จะถ่ายเลยนะครับว่า เราอยากได้แบบไหน เพราะการที่มุมกล้องตรงเป๊ะๆ หรือจะไปเปลี่ยนมุมกล้องทีหลัง

ทุกอย่างพร้อมแล้วก็ลั่น Generate เลย!!

ผมได้ผลลัพธ์ยังไง

ผมลองให้ดูทั้ง 2 แบบ ทั้งแบบ Chacter Match Video กับ Image เลย แต่ความยาวไม่เท่ากันนะ

แบบ match video

ด้วยความที่ผมใช้ภาพที่ gen มาไม่ตรงกับ มุมกล้องใน video ดีเท่าไหร่นัก การแสดงสีหน้าผมเลยดูแปลกๆ แต่ก็ถือว่าไม่แย่ครับ กับการเริ่มต้น

แบบ match image

อันนี้ตรงตามในภาพฝัน เนียนกริ๊บ แต่สั้นจังโว้ย!!

อย่างที่บอกครับ คิดก่อนถ่ายมาดีๆ ไม่งั้นแล้วเดี๋ยวเสียเวลาถ่ายใหม่ gen ใหม่ เปลืองกว่าเดิม

ผมเสียเงินไปเท่าไหร่

KLING AI

ความคุ้มค่า: สำหรับคนลงคลิปทุกวัน อาจจะไม่คุ้ม (ตกคลิปละ 30-40 บาท) แต่ถ้าเน้นคุณภาพ หรือทำคลิปขายของ นานๆ ครั้ง ลงทุนหลักร้อยถือว่าคุ้มค่าครับ

เทียบกับจ้างคน หรือเช่า Studio ถือว่าประหยัดไปเยอะมาก (ถ้าใช้เป็น)

อนาคตจะใช้จริงได้ไหม

ตอนนี้อาจจะไม่น่าใช้เท่าที่ควรถ้าต้องลงคลิปทุกวัน แต่ยังไงมันก็จะหาทางถูกลงได้เรื่อยๆ แล้วตอนนั้นผมก็คงจะหยิบมาใช้ได้แน่ๆ (รอวันที่ถูกกว่าการซื้อกล้องและจัดห้องรวมกันก่อน)

แต่ในตลาดก็มีของที่ถูกกว่านี้นะครับอย่าง model ที่ชื่อว่า

WAN 2.2 animate ก็ถูกกว่า หรือ Infinite Talk แล้วพวก opensource ด้วย เราสามารถติดตั้งบนเครื่องตัวเองได้ (ถ้าการ์ดจอแรงพอ) หรืออาจจะไปเช่า GPU on Cloud ก็ได้ ซึ่งน่าจะถูกกว่าใช้ Kling AI ไปเกิน 10x แน่ๆ แต่สำหรับคนทั่วไปผมไม่แนะนำหรอกครับ

ขนาด programmer อย่างผมยังรู้สึกว่าเอาเวลาเรียนของพวกนี้ ไปทำ product ตัวเองก่อนดีกว่า

Q & A

ถามได้เลยครับ ตอบได้ตอบ ตอบไม่ได้ก็เดี๋ยวไปหามาแปะให้ใน discord ครับ